Видеолекция 8 9 ТВ и МСТ

Информация о загрузке и деталях видео Видеолекция 8 9 ТВ и МСТ

Автор:

Dilfuza EshmamatovaДата публикации:

05.12.2020Транскрибация видео

Значит, продолжаем закон больших чисел, уважаемые студенты.

Только что мы с вами рассмотрели, значит, неравенство Чебышева.

Теперь я бы хотела обратить ваше внимание на теорему Чебышева.

Экран виден, ребята?

Да, да, видим.

Теперь, что говорит неравенство Чебышева?

Теперь, значит, если, вот смотрите, мы рассмотрим x1, x2 и так далее, xn, то есть n попарно-независимых случайных величин, n штук их.

Теперь, значит, причем дисперсии их, всех их этих случайных величин,

равномерно ограничены и не превышают числа s, константы какого-то.

Тогда, как бы мало не было положительное число ε, которое мы с вами рассмотрели, значит, мы берем среднее их арифметическое, вот как вы видите, x1 плюс x2 и так далее, плюс xn, деленное на n, минус, и среднее арифметическое,

их математических ожиданий.

И по модулю оказывается вот это выражение меньше эпсилона.

То есть, если мы возьмем, что говорится, оказывается вот это выражение максимально близка к единице.

Если случайное число всех этих случайных величин, чем больше мы берем этих случайной величины,

который, значит, для которого выполняются вышеуказанные условия, то оказывается разность между ними максимально близка к единице, то есть

Теперь, то есть лимит, вероятность вот этого выражения, которое мы с вами посмотрели, равно единице, ребята.

Таким образом, что говорит теорема Чебышева?

Оно говорит, что если рассматривается достаточно большое число независимых случайных величин,

имеющие ограниченные дисперсии, тогда почти достоверным можно считать событие, состоящее в том, что отклонение среднеарифметического случайных величин от их среднего арифметического, их математических ожиданий, будет по абсолютной величине сколь угодно малым.

То есть,

Теперь, смотрите, я вас сильно напрягать не буду с доказательством, я вам отдельно скину эту, как говорится, презентацию, вы сами почитаете доказательства.

Хочу ваше внимание уделить на вот что.

Давайте рассмотрим, значит, n случайных величин.

И пусть каждый из них имеет одинаковое математическое ожидание, то есть пусть оно равно а, ребята, числу а, допустим, да.

Теперь рассмотрим теорему Чедышева для частного случая.

Если мы рассмотрим попарно независимые n штук случайной величины x1, x2 и так далее, xn,

имеющая одно и то же математическое ожидание, и если дисперсии этих случайных величин равномерно ограничены, как я выше сказала, и то, какое бы ни было маленькое число ε, то есть как бы оно близко не было нулю, вероятность вот этого неравенства, то есть среднеаргументической этих всех случайных величин, минус, значит, их...

математическое ожидание по абсолютному величине меньше эпсилона оказывается равно единице.

То есть, чем больше вы берете количество этих случайных величин, то тем быстрее можно рассмотреть, что вероятность того, что вот это событие, то есть среднее альфметическое, их минус, их математическое ожидание по абсолютному величине меньше эпсилона, предел его равно единице.

В чем сущность этой теоремы?

Она заключается в том, что хотя отдельные независимые случайные величины могут принимать значения далекие от своих математических ожиданий, то среднее арифметическое достаточно большого числа случайных величин с большой вероятностью принимает значения, близкие к определенному постоянному числу.

а именно к какому числу, что среднее арифметическое их математических ожиданий.

Но мы его взяли равно, то есть мы сказали, что они имеют одинаковые математические ожидания.

То есть отдельные случайные величины могут иметь значительный разброс, а их среднее арифметическое рассеяно очень мало.

То есть среднее арифметическое, они не так сильно рассеяны, как сами они, эти случайные величины.

То есть что мы хотим сказать?

Я хочу сказать, что какое возможное значение примет каждый из этих случайных величин, можно предвидеть, какое значение примет их среднее арифметическое этих всех случайных величин.

Теперь, то есть среднее арифметическое достаточно большого числа независимых случайных величин,

Только условия их диспенсии должны быть равномерно ограничены.

Утрачивает характер случайности.

Это объясняет, что отклонения каждой из случайных величин от своих математических ожиданий могут быть так же положительными, как и отрицательными.

А в среднем арифметическом они взаимно погашаются.

Значит, эта теорема, теорема Чебышева, то есть она справедлива не только для дискретных случайных величин, как я вам сказала, она справедлива и для непрерывных случайных величин.

Теперь теорема Бернули.

Давайте посмотрим теорему Бернули.

Значит, пусть производится n независимых испытаний.

в каждом из которых вероятность появления события А равно П. То есть мы проводим независимые испытания, в каждом из них вероятность события А одинаковая, одно и то же.

Можно ли предвидеть, какова будет примерно относительная частота?

То есть мы только что смотрели вероятность, а здесь рассматриваем относительную частоту появления этого события.

На этот вопрос дает теорема, доказанная якобы Бернули, которую мы только что рассмотрели в 1713 году.

Теорема получила название «Закон больших чисел», и эта теорема поставила большой шаг, то есть это открытие, как бы начало теории вероятности как науки.

Это в 1713 году, это была как бы революция в этой сфере, то есть открылась, открылся чисто теория вероятности и математическая статистика, вот этот предмет как, ну,

Как наука начала изучаться, начиная с этой теоремы.

Доказательство этой теоремы было очень сложным.

Самое простое доказательство, упрощенное, все-таки доказало его, вы как видите, почти через век Чебышев дал доказательство.

Ну, первоначально давайте посмотрим, сама теорема, трактовка теоремы не изменилась, только доказательство намного проще доказал через, ну, сколько получается, да, больше века, как вы видите, полтора века, да, считайте, как бы.

В каждом, что говорит теорема?

Мы рассматриваем N независимые испытания, в каждом из которых вероятность появления события A одинаковая.

Тогда

Как угодно близка к единице вероятность того, что отклонение относительной частоты от его, от ее вероятности рассматриваемой.

То есть что было у нас, что такое вероятность вообще и что такое...

как его, относительная чистота, вероятность, это мы с вами делаем прогноз, а относительная чистота мы уже анализ делаем, то есть мы с вами, опыт произошел, мы с вами анализируем факт,

Оказывается, вероятность того факта, то есть относительной частоты и разности этих вероятностей по абсолютной величине меньше, чем ε, предельно равно единице.

событий.

Чем больше берем независимых испытаний, тем больше у нас получится... Чем быстрее у нас будет равно единице.

Теперь, доказать тоже я вас этим мучить не буду, ребята, но вы сами теоремы обязаны знать.

В тестировании это у меня есть.

Давайте посмотрим практическое применение.

Сейчас, секундочку.

Нет, маленькие теоремки дам я вам лучше, потом вернемся к практическому применению.

Теорема пуассона.

Если...

Мы возьмем последовательность независимых испытаний, вероятность в каждом из которых вероятность события А. Ну, допустим, в К там испытание равно ПК.

Тогда при любом Эпсилоне, ребята, вот мы берем М, Мю деленное на Н, то есть это у нас число появления события А в первом Н испытаниях.

И среднее арифметическое их вероятности будет меньше, чем 1, и псилона также будет равно 1.

Это дает нам теорема Пуассона, ребята.

Значит, что я хочу вам сказать.

Вот мы с вами рассмотрели, ребята, закон больших чисел для...

данные теоремы показали для дискретных случайных величин.

На этом, в принципе, вот смотрите, ту часть, которая зависит от, то есть та часть, которая называется теория вероятности, мы с вами закруглились.

Вот теперь у меня одна лекция последняя посвящена элементам математической статистики.

В чем заключаются элементы математической статистики?

То есть в чем заключается наш план?

Смотрите, основные понятия – совокупность, генеральная и выборочная.

Два вида совокупности.

Гистограмма, статистические характеристики, выборочные оценки, ребята.

Потом точечная оценка математического ожидания дисперсии среднего квадратического отклонения случайной величины по выборке.

Доверительная, то есть интервальная оценка, по-другому можно так сказать, математического ожидания случайной величины по выборке.

Потом проверка гипотезы о достоверности разности средних значений в двух выборочных совокупностях.

Но если успеем, корреляционная зависимость между случайными величинами, регрессия, коэффициенты корреляции и регрессии, потом метод наименьших квадратов, оценки коэффициентов нашей регрессии и корреляционная зависимость между изучаемыми признаками, то есть коэффициент корреляции Спирмана.

Что такое математическая статистика?

Это, оказывается, наука о математических методах, ребята, систематизации статистических данных.

Также их используют для решения научно-практических задач.

Что такое статистические данные?

Это данные, которые носят случайный характер при массовых измерениях.

Теперь,

Основные понятия математической статистики.

В чем заключается?

Совокупность – это множество объектов, объектов, обладающих хотя бы одним общим свойством.

Теперь, объем совокупности – это число элементов совокупности, оно обозначается через n или n. Сейчас, секундочку, ребята.

Теперь, что такое объем совокупности?

Это число элементов совокупности, сколько там чисел, то есть просто количество элементов это совокупности.

Давайте продолжим, ребята.

Вы меня слышите?

Так.

Теперь смотрите, ребята, генеральная совокупность.

Что такое генеральная совокупность?

Оказывается, генеральная совокупность... Сейчас, ребята, у меня со связью проблемы.

У меня со связью проблемы.

Сейчас, секундочку, ребята.

Значит, смотрите.

Что такое генеральная совокупность?

Это оказывается...

Сейчас, секундочку, ребята, что-то у меня.

Так, это наибольшая совокупность элементов, обладающих хотя бы одним общим свойством.

Число элементов, оно n. Выборочная совокупность, это часть генеральной, ребята, которая у нас.

Совокупность выбранная для изучения, которую часть мы хотим изучить.

И количество элементов, это n маленькая.

Теперь,

Ребята, если так посмотреть, значит, сейчас секундочку.

Давайте пример посмотрим.

Вы меня слышите, ребята?

Да, да.

Так, теперь.

Сейчас секундочку.

Так, демонстрацию экрана включу.

Сейчас, подождите.

Так, значит, например, все студенты земного шара, так, общий признак это студент, это генеральная совокупность.

Теперь, смотрите, студенты, например, у какого-то вуза первого курса, пять факультетов, группы 39, например, это выборочная совокупность у какого-то, если вы какой-то курс берете.

Теперь, статистические характеристики.

В чем это значит?

Знаете, я вот пример вам показал.

Например, хотите вы изучить, например, одну группу всего университета.

Например, вот белорусский филиал.

Вот у вас сколько?

Первый, второй курс, например, 300 человек.

У вас хотят изучить одну группу, например, вашу группу.

Все студенты, вот эти 300 человек, это генеральная совокупность, выборочная совокупность, например, группа 4Б.

Поняли, да, меня?

То есть, если я хочу изучить, то я выделяю ту часть, которую... Объем всей генеральной совокупности это 300 будет, а объем этой выборочной, вот сколько у вас 12, значит, будет равно 12.

Теперь, какие характеристики, какие статистические характеристики?

Это числовые характеристики, которые дают оценку характер нашей совокупности.

Это первое математическое ожидание, здесь так же.

Второе – дисперсия.

Третье – среднее квадратическое отклонение.

Значения статистических характеристик могут быть истинными, то есть они определяют по генеральной совокупности, или выборочными, определяются по выборке, который я хочу, мы, например, хотим изучить.

Выборочные оценки значения статистических характеристик называются выборочными оценками.

Это оценки статистических характеристик.

Значит, это значения, полученные при изучении выборки.

Их используют для чего?

Для того, чтобы вместо истинных значений статистических характеристик генеральной совокупности.

Они бывают в точечной оценке.

Это численное значение оптимальной выборочной оценки.

Точечная оценка – это численное значение оптимальной выборочной оценки статистической характеристики.

Доверительная оценка или интервальная оценка – это доверительный интервал для истинного значения статистической характеристики.

Теперь давайте посмотрим точечную оценку.

Оптимальная выборочная оценка –

математического ожидания.

Чему равно?

Вы берете среднее, то есть, грубо говоря, среднее арифметическое значение выборки.

Это называется оптимальная выборочная оценка математического ожидания.

n – число элементов выборки, которые вы выбрали.

Например, 12 человек у вас, x – значение случайной величины, а x – шапочка, обозначаем среднее выборочное.

Оптимальная выборочная оценка дисперсии.

Что это такое?

Значит, 1 деленное n минус 1, также n это количество элементов выборки, сумма и от 1 до n, x и минус среднее, которое мы с вами только что вычислили.

И в квадрат возводим.

Вот, пожалуйста, это оказывается оптимальная выборочная оценка дисперсии, ребята.

Сейчас, секундочку.

Так.

Сейчас, секундочку, ребята, я уберу это.

Сейчас, звук увеньшился из этого.

Так, теперь смотрите.

Две секунды.

Значит, как я вам сказала, мы рассмотрим два вида.

Значит, когда n больше равно 30, когда в таком случае мы с вами можем

Если n больше равно 30, выборочную оценку можно принять в качестве истинного значения дисперсии, то есть считать величину dx известно.

x шапочка минус tau, так называется, альфа, квадратный корень дисперсии, деленное на n, и среднее, которое мы с вами посчитали, плюс tau умноженное на квадратный корень dx на n.

ТАО находится, у нас есть таблица Лапласа, функция Лапласа, если вы помните, первое-второе приложение любого задачника по теории вероятности.

Как я вам сказала, в биологических медицинских исследованиях обычно там уже стандартное альфа равно 0,95, p равен 0,05.

В этом случае ТАО альфа считает 1,96.

Если n у нас меньше 30, ребята,

Тогда дисперсия неизвестна.

То есть тогда математическое ожидание будет разность от среднего значения минус tau умножено s деленное на корень из n и x плюс tau умножено s деленное на корень из n. k – это число степеней свободы, равен n-1, а αk – это коэффициент стюдента.

Теперь, как мы проверяем статистические гипотезы, ребята?

Проверка гипотезы о достоверности разности средних значений двух выборочных совокупностей, то есть нулевая гипотеза.

Нулевая гипотеза принимается когда?

Если изучаемые выборки относятся к одной генеральной совокупности.

То есть, следовательно, отсюда отличие между средними выборочными этих выборок является случайными, недостоверными.

Нулевая гипотеза отвергается, если выборка относится к разным генеральным совокупностям.

И тогда отличие между средними выборочными достоверны, ребята.

Теперь, процедура анализа выбора какова?

Это оказывается равно, k равен числу степеней свободы, значит, n1 плюс n2 минус 2.

И h у нас равен n1 минус 1 умножено, значит, s1 в квадрате плюс n2 минус 1, s2 в квадрате.

t находится по этой, как его, значении t, вот по этой формуле.

Если у вас t больше t, тогда разность средних выборочных всегда достоверна, ребята.

Если t меньше, то разность не является достоверной.

t это что?

Это коэффициент стюдента.

объемы обоих выборок, как в таком случае, если объемы обоих выборок велики и приблизительно равны между собой, тогда вычисление вот этого t используют намного проще формулу.

Вот по этой формуле, ребята.

Вы меня слышите, ребята?

Да, да.

Теперь, смотрите, элементы корреляционного и регрессионного анализа.

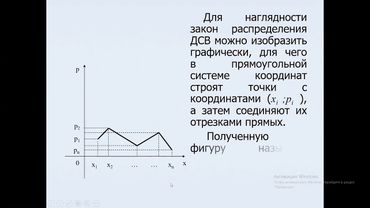

Если зависимость между величинами заключается в том, что каждому значению одной случайной величины соответствует свой определенный закон распределения другой случайной величины, то при этом говорят уже не просто о плотности вероятности случайной величины, а о ее условной плотности вероятности.

Например, условная вероятность

Условная плотность вероятности величины y, то есть это f, y при условии x. Это плотность вероятности y при указанном значении x. Если условная плотность вероятности величины y зависит от величины x, а условная плотность вероятности величины x зависит от величины y,

В таком случае говорят, что между величинами y и x существует корреляционная зависимость.

То есть, еще раз повторяю, если y зависит от x, а x зависит от y, в таком случае, то есть двух сторон, между ними существует корреляционная зависимость.

Если плотность вероятности случайной величины y зависит от случайной величины x и математическое ожидание вероятности y зависит от этой величины, тогда только тогда мы можем говорить об условном математическом ожидании величины y при заданном значении x.

Вот, пожалуйста.

Функция φx называется в таком случае функцией регрессии y на x. График этой функции называется линией регрессии.

Если в выражении этой функции присутствуют какие-нибудь постоянные коэффициенты, то эти коэффициенты называются коэффициентами нашей регрессии.

Точно так же мы можем ввести понятие функции регрессии x на y. То есть

x на y. Здесь функция y это функция регрессии x на y, ребята.

Вот такие, вот что я хотела сегодня с вами поговорить.

То есть мы с вами сегодня что?

Закончили теорию вероятности полностью.

Все темы я с вами закончила.

И тема, значит, у нас сегодня мы с вами рассмотрели элементы математической статистики.

Ребята,

Вы меня слышите?

Ага.

Мне бы хотелось с вами уточнить день, когда мы с вами сможем.

Мне нужно практическое занятие провести.

Когда у вас будет свободно более-менее?

Я могу завтра.

Завтра в 11.

С 11 4 пары у нас.

А, у вас 11 4 пары.

А в четверг как у вас?

Посмотрите четверг, да.

Мне надо практику закончить.

Буквально вот как сегодня, два по полчаса хотя бы, чтобы я с вами теорию вероятность порешала и по статистике несколько задач, чтобы вам не было сложно.

Спасибо.

В среду могу, утром.

Завтра.

Ой, нет, нет.

В среду утром могу, но во сколько?

Сейчас скажу.

Ну, где-то так же, в 11 могу в среду.

Если сейчас не сможем решить, еще раз зайдете, мы с вами уточним, ребята.

Вот.